Los datos cuentan una historia, y los expertos deben ser capaces de crear la arquitectura necesaria para almacenar y tratar correctamente esos datos, de manera que sea posible visualizar el conocimiento que se esconde tras la información y obtener valor.

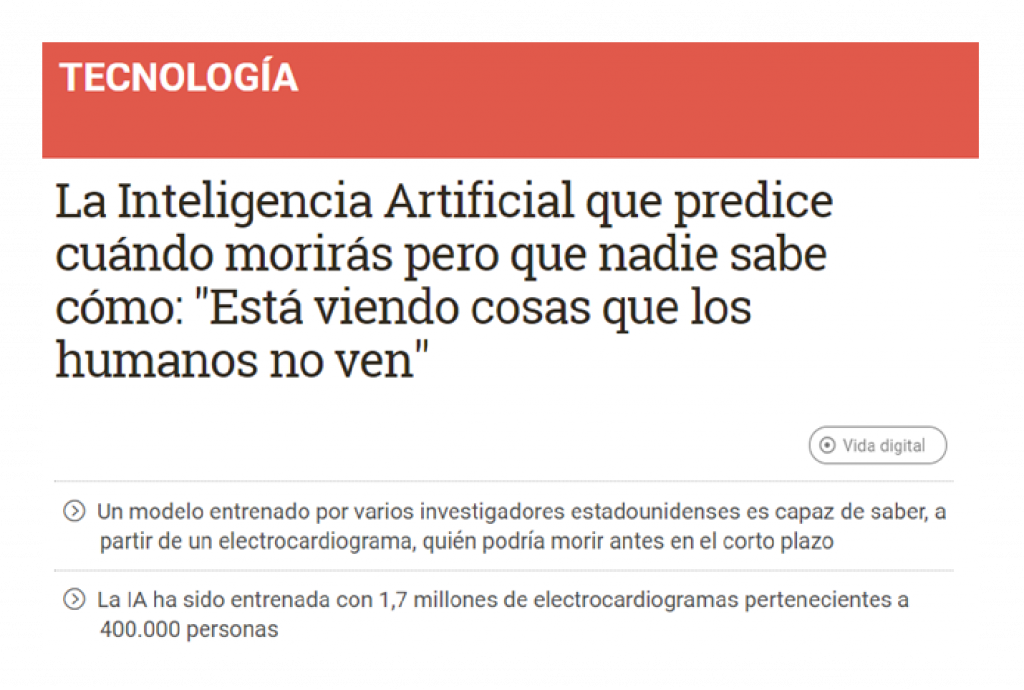

Nada mejor que comenzar con un claro ejemplo de cómo a través de la utilización de los datos que tienen en su poder las organizaciones, estas pueden llegar a conseguir resultados. Este ejemplo en concreto se basa en el análisis de electrocardiogramas y, para llegar a la solución del problema, se ha utilizado un histórico de 1,7 millones de cardiogramas. A partir de ese histórico, se lleva a cabo un análisis de los datos y, posteriormente, basta con hacer uso de la Inteligencia Artificial para poder realizar predicciones.

La red neuronal es capaz de anticipar, antes que los médicos, los patrones erráticos en los electrocardiogramas; tres cardiólogos revisaron por separado los electrocardiogramas considerados «normales» y que la máquina había etiquetado como peligrosos. Ninguno de ellos pudo detectar los patrones en los que la máquina se basó para calificar los ECGs como «de riesgo»

Gracias a Big Data podemos almacenar y tratar grandes cantidades de datos[dt_divider style=»thin» /]

Por tanto, un comienzo para obtener ese valor es crear un histórico suficientemente importante y de calidad, es decir, un Data Lake o lago de datos. Este histórico deberá estar basado en un esquema de almacenamiento distribuido (HDFS), en el que cada nodo almacena un fragmento de la información.

A través de la programación distribuida podremos realizar consultas, filtros, e indexación sobre dichos datos, con un bajo tiempo de respuesta.

Gracias al análisis de datos se pueden: identificar, evaluar y aprovechar oportunidades, y así generar valor para la organización.

En el análisis de datos, entre los métodos para obtener valor de los datos, se utilizan:

- Análisis de la información

- Herramientas de visualización

- Modelos para la toma de decisiones

Ciclo de vida del dato[dt_divider style=»thin» /]

Seguir el ciclo de vida minimiza riesgos a la hora de desarrollar un sistema de análisis. Las fases mínimas que debe incluir este ciclo son:

- Identificación de las fuentes de datos que serán necesarias (Casos de uso)

- Recopilación de la información (creación del Data Lake e ingesta de datos)

- Calidad del dato

- Análisis de los datos

- Visualización Inicial

- Desarrollo y tratamiento de los datos

- Resultados y visualización final

Desarrollando un proyecto de analítica de datos siguiendo el ciclo de vida[dt_divider style=»thin» /]

Fase 1: Identificación de los datos que serán necesarios (Casos de uso)

En esta fase se deben identificar los Casos de uso de nuestro sistema analítico.

Una vez tenemos claro el alcance de nuestro proyecto a través de los casos de uso, deberemos de ser capaces de identificar las fuentes de datos necesarias para llevar a cabo el desarrollo de nuestra funcionalidad. En algunos casos, estas fuentes de datos pueden ser internas, pero quizás sea necesario recopilar datos externos u open data (datos meteorológicos, gubernamentales, etc.).

Fase 2: Recopilar la información (creación del Data Lake e ingesta de datos)

Para la creación de una plataforma analítica, antes es necesario crear todo el Data Lake donde ingestar los datos que se utilizarán.

Fase 3: Calidad del dato

Se comprueba que los datos tienen la calidad suficiente para no correr riesgos en los resultados que se puedan ofrecer en las fases analíticas descriptivas y/o predictivas.

Tendremos que evaluar la protección y privacidad del dato con el que trabajamos, estableciendo los niveles adecuados de seguridad y confidencialidad del dato, en función de su naturaleza y tipología.

Fase 4: Análisis de los datos

Esta fase comienza por una inspección inicial de los datos e identificación de los principales KPI’s a medir.

Análisis descriptivo: El objetivo es resumir una gran cantidad de datos para que puedan ser entendibles. De esta forma, será posible tomar medidas que se adapten a los objetivos de la organización.

En esta fase, se suelen utilizar herramientas de visualización para bucear en los datos y poder entender con mayor detalle el valor que alberga la información.

Análisis predictivo: Aplicación de técnicas matemáticas o estadísticas para pronosticar qué podría suceder, y así tomar las medidas necesarias para la solución de problemas.

La importancia del Gobierno del Dato[dt_divider style=»thin» /]

El gobierno de datos consiste en la capacidad de una organización para gestionar el conocimiento que tiene sobre su información, de forma que pueda responder a preguntas tales como:

¿Qué sabemos sobre nuestra información?

¿De dónde provienen esos datos?

¿Están estos datos alineados con nuestra política de empresa?

¿Quién tiene acceso a estos datos?

¿Quién va a tener acceso a la información tratada?

Existen dos tendencias respecto a la gestión del gobierno del dato.

-

- Gestión centralizada: En algunos departamentos, pueden ver el valor en centralizar la gestión de los datos creando un departamento focalizado en esta labor.

- Descentralizada: Otros departamentos suelen mostrarse reacios a permitir que terceras partes accedan a sus datos, y por supuesto tampoco quieren que este organismo los corrija, manipule o interprete. En este caso, el departamento puede desarrollar y llevar a cabo su propia estrategia de análisis de datos.

Modelos de predicción[dt_divider style=»thin» /]

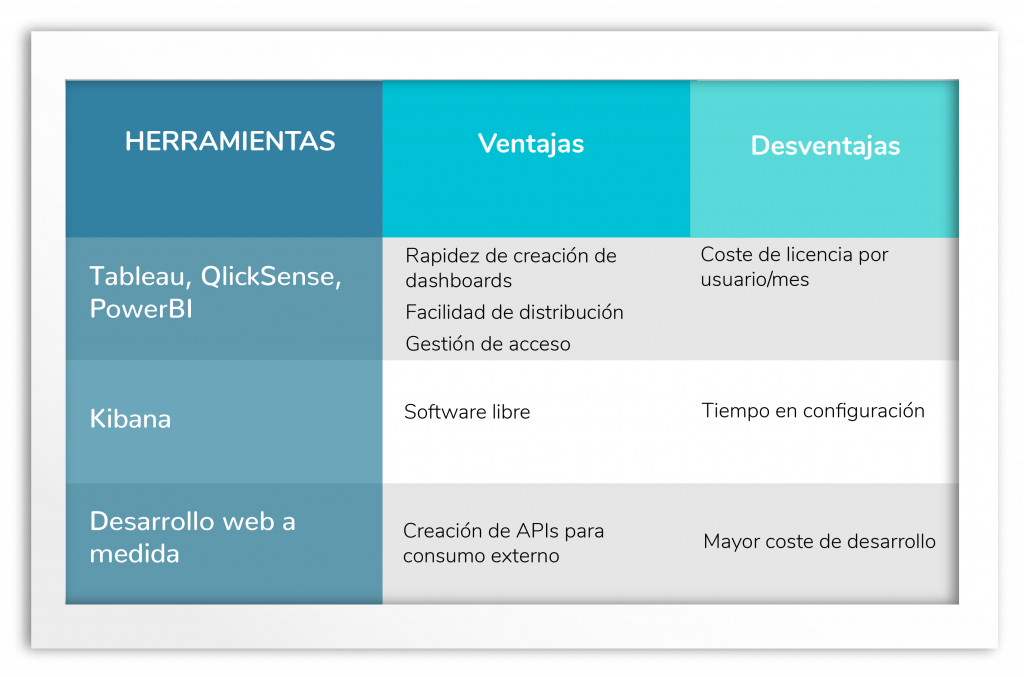

Visualización o representación de los datos a través de la definición de dashboards e informes, de cara tanto a la información inicial como a los resultados que ofrecen los modelos predictivos.

Visualización: Dashboards e informes[dt_divider style=»thin» /]

La visualización de datos, nos permitirá llevar a cabo un correcto análisis de los mismos, además de brindarnos la posibilidad de comunicar de una manera más eficiente. La visualización gráfica de datos constituye una disciplina propia dentro del universo de la ciencia de datos.

En 1963, la compañía de aerolíneas norteamericana Pam Am utilizó la representación gráfica (la serie temporal entre 1949 y 1960), del número mensual de pasajeros internacionales para pronosticar la demanda futura de aviones y realizar un pedido de compra.

Casos de uso: Mantenimiento predictivo (PredictiveMaintenance, PdM)[dt_divider style=»thin» /]

El mantenimiento predictivo se basa en el seguimiento continuo del rendimiento de equipos o sistemas a través de datos recopilados y algoritmos de predicción, para proporcionar una advertencia avanzada de problemas en los equipos.

Gracias a los históricos de los que se dispone, se puede realizar la predicción ante futuros fallos o problemas que se pudieran originar.

Miguel Ángel Ruz Hernández

Miguel Ángel Ruz Hernández

Consultor de Analítica de Datos y Big Data